Marcelo Finger Alan Barzilay

RNN's

Parte 01: Recorrência Neural

Conteúdos

- Recorrência Neural

- Treinamento Recorrente

- Modelos Sequência pra Sequência

- Problemas que Advem da Recorrência

- Soluções para Redes Profundas

Recorrência Neural

Ordem importa, contexto importa

Ao trabalharmos com redes convencionais, não fornecemos nenhuma informação sobre ordem ou sequência dos tokens.

Mas sabemos que o contexto em que as palavras ocorrem em uma frase influencia no seu significado.

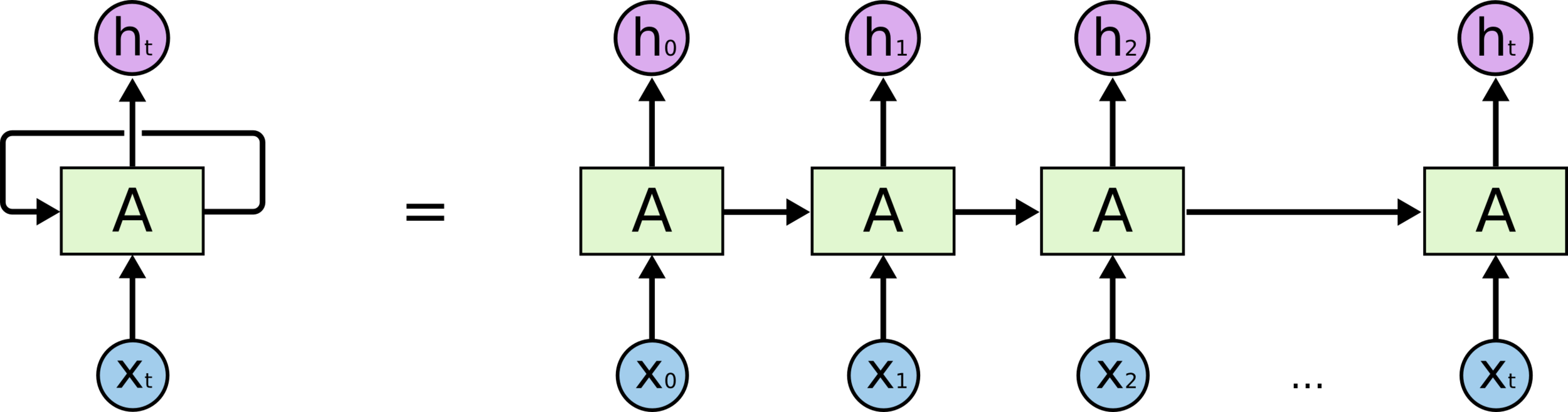

Redes Recorrentes

Ao invés de utilizarmos camadas sequenciais que recebem uma frase inteira de uma vez podemos criar redes que recebem uma palavra por vez e se “realimentam” a cada nova palavra.

Redes Recorrentes

Deixamos de necessitar padding e conseguimos fornecer informação posicional sobre cada palavra através da própria arquitetura da rede.

Redes Feed Forward

-

Cada iteração é independente.

-

Facilmente paralelizável.

-

Alimentamos toda uma sequência de tokens de uma vez.

Redes Recorrentes

-

Cada iteração depende da anterior.

-

Sequencial por natureza, menor oportunidade de paralelização.

-

Alimentamos um token de cada vez de maneira sequencial

Redes Feed Forward

Redes Recorrentes

Representação “desenrolada”

Representação “desenrolada”